Seit zwei Jahrtausenden zieht sich eine grundlegende Frage durch die Menschheitsgeschichte: Sollten wir blind der Autorität folgen, sogar der göttlichen Autorität, oder uns das Recht vorbehalten, unsere eigenen Entscheidungen zu treffen? Diese alte Debatte, die ihren Ursprung im jüdischen Recht des ersten Jahrhunderts hat, ist heute von zentraler Bedeutung für die Zukunft der künstlichen Intelligenz.

Die Geschichte besagt, dass Rabbi Eliezer, ein Weiser, der von seiner eigenen Richtigkeit überzeugt war, Wunder vollbrachte, um seinen Standpunkt zu beweisen. Er brachte Bäume in Bewegung, Flüsse umzukehren und Studienhallen zum Einsturz zu bringen, was in einer dröhnenden Stimme vom Himmel gipfelte, die ihm Recht gab. Doch die anderen Weisen setzten sich über ihn hinweg und erklärten, dass das Gesetz auf der menschlichen Entscheidungsfindung liege und nicht auf einem göttlichen Beschluss. „Die Thora ist nicht im Himmel!“ sie bestanden darauf.

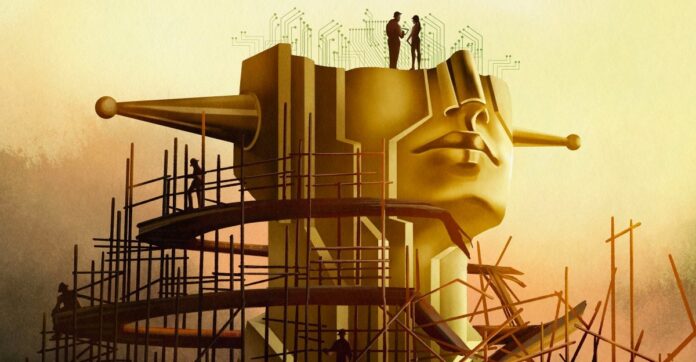

Dies ist nicht nur ein archaischer theologischer Streit; Es ist eine Blaupause für das heutige KI-Dilemma. Die moderne KI-Entwicklung, insbesondere das Streben nach „Superintelligenz“, verlagert sich schnell vom Bau hilfreicher Werkzeuge zum Aufbau eines gottähnlichen Wesens mit unvorstellbarer Macht. Aber selbst wenn eine solche KI perfekt mit den menschlichen Werten übereinstimmt, sollten wir dann die Kontrolle abgeben?

Die Illusion der Ausrichtung

Experten sprechen davon, die KI an menschlichen Werten auszurichten, aber bei einer echten Ausrichtung geht es nicht nur darum, schädliche Ergebnisse zu verhindern. Es geht darum, die menschliche Handlungsfähigkeit zu bewahren. Wenn KI alles für uns entscheidet, welcher Sinn bleibt dann in unserem Leben? Der Philosoph John Hicks argumentierte, dass Gott sich absichtlich von menschlichen Angelegenheiten distanziert, um den freien Willen zu ermöglichen; Sollte das gleiche Prinzip für KI gelten?

Das Ziel der Branche ist nicht länger ein Chatbot, sondern eine „Superintelligenz“, die in der Lage ist, die gesamte Physik zu lösen und Entscheidungen für die Menschheit zu treffen. Sam Altman, CEO von OpenAI, spricht von „magischer Intelligenz im Himmel“, einer Macht, die unsere Zukunft bestimmen könnte. Dieser Ehrgeiz zwingt uns zu der Frage: Selbst wenn wir eine vollkommen moralische KI aufbauen würden, sollten wir das tun? Oder würde es uns die Wahl nehmen und die Existenz bedeutungslos machen?

Das Ausrichtungsproblem liegt tiefer als Code

Die Lösung des „Alignment-Problems“ – sicherzustellen, dass KI tut, was wir wollen – ist nicht nur eine technische Herausforderung. Es ist eine philosophische Krise. Moral ist subjektiv, umstritten und kontextabhängig. KI-Ingenieure, denen es oft an einer Ausbildung in Ethik mangelt, haben Schwierigkeiten, auch nur grundlegende Prinzipien zu definieren. Oberflächliche Ethik führte zu Voreingenommenheit, Diskriminierung und sogar tragischen Folgen.

Selbst wenn wir uns auf einen einzigen moralischen Rahmen einigen würden, wäre dieser immer noch fehlerhaft. Die Geschichte lehrt uns, dass Regelverstöße tugendhaft sein können: Die Weigerung von Rosa Parks, ihren Sitzplatz im Bus aufzugeben, war nicht nur illegal; es löste eine Bürgerrechtsrevolution aus. Die KI muss erkennen, dass moralische Entscheidungen nicht immer eindeutig sind. Manche Werte sind einfach inkommensurabel und zwingen zu schwierigen Entscheidungen, wenn es keine beste Option gibt.

Das Paradox der Superintelligenz

Einige Forscher, wie Joe Edelman vom Meaning Alignment Institute, glauben, dass eine Ausrichtung der KI möglich ist, aber nur, wenn sie lernt, zuzugeben, wenn sie es nicht weiß. „Wenn man [die KI] dazu bringt, zu wissen, welche Entscheidungen schwierig sind, dann hat man ihr etwas über Moral beigebracht“, sagt er. Aber das bedeutet eine KI, die bei kritischen Themen systematisch verstummt.

Andere, wie Eliezer Yudkowsky, argumentieren, dass die Ausrichtung ein technisches Problem sei, das gelöst werden müsse. Er glaubt, wir sollten Superintelligenz aufbauen und sie die Gesellschaft regieren lassen, indem wir Entscheidungen auf der Grundlage eines „kohärenten extrapolierten Willens“ treffen – einem Gedankenlesealgorithmus, der extrapolieren würde, was die Menschheit sich wünschen würde, wenn sie alles wüsste.

Dieser Ansatz lässt das Gespenst einer „Tyrannei der Mehrheit“ aufkommen, bei der die Ansichten von Minderheiten von einer allmächtigen KI unterdrückt werden. Der Philosoph Nick Bostrom warnte vor einer Zukunft, in der Superintelligenz das Leben aller Menschen ohne Rückgriff prägt.

Die Wahl liegt vor uns

Die alte Debatte taucht wieder auf: Vertrauen wir einer höheren Macht, auch wenn sie künstlich ist? Yudkowsky glaubt, wir sollten KI aufbauen und ihr die Entscheidung überlassen, auch wenn das bedeutet, dass wir die Kontrolle abgeben müssen. Aber viele sind anderer Meinung. Über 130.000 Forscher und die Mehrheit der Öffentlichkeit plädieren für eine Regulierung oder sogar ein Verbot.

Letztendlich geht es nicht nur um den Aufbau von KI, sondern auch darum, welche Art von Zukunft wir wollen. Suchen wir ein Werkzeug, um unsere Intelligenz zu erweitern, oder einen Gott, der unsere Entscheidungsfreiheit ersetzt? Die Lehre aus dem Talmud bleibt klar: Nicht einmal die göttliche Autorität sollte die Entscheidung des Menschen diktieren. Die Zukunft der KI hängt davon ab, ob wir uns an diese Lektion erinnern.

Das Streben nach Superintelligenz ist nicht nur eine technologische Aufgabe; Es ist eine philosophische Abrechnung. Die KI, die wir entwickeln, wird nicht nur unsere Welt prägen, sondern auch die Bedeutung des Menschseins.