Революція навчання ШІ: як уникнути «забудькуватості» великих мовних моделей і заощадити мільйони

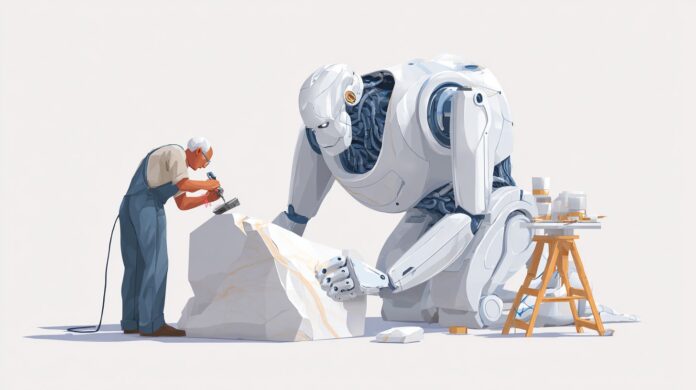

У світі, де великі мовні моделі (LLM) стають невід’ємною частиною бізнесу, починаючи від чат-ботів і закінчуючи генерацією контенту, питання того, як їх ефективно та економічно ефективно навчати, стає критичним. Не секрет, що підготовка і перепідготовка цих гігантів вимагає величезних обчислювальних ресурсів, часу і, головне, фінансових вкладень. У той же час традиційний підхід до перенавчання часто призводить до неприємного явища – «катастрофічного забування», коли модель втрачає частину своїх попередніх знань і навичок.

Недавнє дослідження Університету Іллінойсу відкриває нову главу в цій історії, пропонуючи елегантне вирішення проблеми «забудькуватості» та обіцяючи значну економію для компаній, які використовують LLM. Замість того, щоб перенавчати всю модель, дослідники пропонують зосередитись на невеликих, вузьких сегментах, щоб уникнути переобладнання та зберегти цінні знання.

Що таке «катастрофічне забування» і чому це проблема?

Уявіть, що ви навчите дитину грати в шахи, а потім почнете вчити її грати в го. Якщо ви надто зосереджуєтеся на Го, ваша дитина може почати забувати основи гри в шахи. Те ж саме відбувається з LLM. При перенавчанні для вирішення нової проблеми модель може «забути» те, що вона вже знала. Це особливо важливо для моделей, які повинні виконувати широкий спектр завдань, а не лише одне.

Традиційно боротьба із забуванням вимагала складних і ресурсомістких методів, таких як тиражування даних або використання спеціальних регуляторів. Однак ці методи часто неефективні та додають ще більше витрат на навчання.

Ключове відкриття: «забуття» — це не втрата пам’яті, а зміна розподілу

Дослідники з Університету Іллінойсу запропонували радикально новий погляд на проблему «забуття». Вони виявили, що те, що ми сприймаємо як втрату знань, насправді є зміною в розподілі результатів. Іншими словами, модель не забуває інформацію, а починає видавати результати, які відповідають новому завданню, але не відповідають старим.

Це відкриття стало справжнім проривом, оскільки дозволило розробити набагато більш ефективний і економічний метод перенавчання. Замість того, щоб намагатися запобігти «забуванню» за допомогою складних коригувань, можна просто зосередитися на невеликих, вузьких сегментах моделі, зберігаючи її попередні знання.

Як працює метод «вузької перекваліфікації»?

Метод базується на фокусі на багатошаровому персептроні (MLP), внутрішньому компоненті моделі прийняття рішень. Дослідники виявили, що налаштування MLP призвело до збільшення ймовірності випуску числових токенів і зниження точності. Щоб уникнути цього, вони пропонують налаштувати лише прогнози MLP вгору/стробування, зберігаючи прогнози вниз замороженими.

Це дозволяє навчатися, подібно до повного налаштування MLP, водночас значно знижуючи ймовірність «забуття». Крім того, цей підхід дозволяє краще контролювати вихідний дрейф, що особливо важливо для додатків, де стабільність і передбачуваність результатів є критичними.

Мій особистий досвід і спостереження

Я працюю в галузі машинного навчання вже більше десяти років, і за цей час я бачив багато підходів до підготовки та перепідготовки LLM. Традиційні методи часто здавалися мені надто складними та ресурсомісткими. Ідея зосередитися на маленьких, вузьких сегментах моделі завжди здавалася мені інтуїтивно зрозумілою, але її практична реалізація завжди була пов’язана з труднощами.

Дослідження Університету Іллінойсу дають чіткі вказівки щодо реалізації цієї ідеї. Особливо вражає те, що дослідники змогли не тільки підтвердити ефективність цього підходу, але й пояснити, чому він працює. Їхнє пояснення щодо змінного розподілу результатів здається мені особливо проникливим.

Практичні наслідки для бізнесу

- Зменшені витрати на навчання: Зосередження уваги на невеликих сегментах моделі може значно знизити витрати на навчання, особливо для великих LLM.

- Покращення стабільності: Більш точний контроль над вихідним дрейфом може покращити стабільність і передбачуваність результатів.

- Більш ефективне використання ресурсів: Зменшення обчислювальних ресурсів, необхідних для навчання, може підвищити ефективність використання ресурсів і зменшити вплив на навколишнє середовище.

- Швидша адаптація до нових завдань: Можливість швидкого перенавчання невеликих сегментів моделі дозволяє компаніям швидко адаптуватися до нових викликів і вимог.

Обмеження та подальші дослідження

Незважаючи на багатообіцяючі результати, важливо враховувати деякі обмеження дослідження. У першу чергу він зосереджується лише на двох моделях щодо бачення та мови. Потрібні додаткові дослідження, щоб переконатися, що цей підхід застосовний до інших LLM, особливо моделей, що використовуються в інших модальностях.

Крім того, було б цікаво дослідити, як цей підхід можна використовувати для навчання моделей, яким потрібно виконувати широкий спектр завдань. Можливо, можна було б розробити систему, яка автоматично визначає, які сегменти моделі потрібно перенавчати для вирішення нової проблеми.

Висновок: нова ера ефективного викладання магістра права

Дослідження Університету Іллінойсу знаменує собою важливий крок вперед у сфері підготовки LLM. Запропонований метод «вузького перекваліфікування» обіцяє значну економію для компаній, які використовують LLM, і відкриває нову еру ефективного навчання. Це не просто технічне вдосконалення, це зміна парадигми, яка може радикально змінити спосіб розробки та використання LLM. У майбутньому ми, ймовірно, побачимо, що більше компаній застосують цей підхід для зниження витрат, підвищення ефективності та стабільності своїх LLM.

Джерело: 3das.com.ua