Durante dos milenios, una pregunta fundamental ha resonado a lo largo de la historia humana: ¿deberíamos seguir ciegamente la autoridad, incluso la autoridad divina, o reservarnos el derecho de tomar nuestras propias decisiones? Este antiguo debate, que se originó en la ley judía del siglo I, es ahora fundamental para el futuro de la inteligencia artificial.

La historia cuenta que el rabino Eliezer, un sabio convencido de su propia corrección, realizó milagros para demostrar su punto. Hizo que los árboles se movieran, los ríos retrocedieran y las salas de estudio se derrumbaran, culminando con una voz retumbante desde el cielo que le dio la razón. Sin embargo, los otros sabios lo invalidaron, declarando que la ley depende de la toma de decisiones humana, no de un decreto divino. “¡La Torá no está en el cielo!” insistieron.

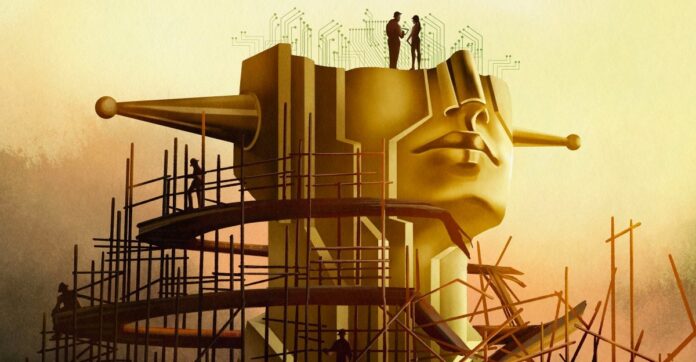

Ésta no es sólo una disputa teológica arcaica; es un modelo para el dilema actual de la IA. El desarrollo moderno de la IA, en particular la búsqueda de la “superinteligencia”, está pasando rápidamente de la construcción de herramientas útiles a la construcción de una entidad divina con un poder inimaginable. Pero incluso si dicha IA estuviera perfectamente alineada con los valores humanos, ¿deberíamos ceder el control?

La ilusión de la alineación

Los expertos hablan de alinear la IA con los valores humanos, pero la verdadera alineación no consiste simplemente en prevenir resultados dañinos. Se trata de preservar la agencia humana. Si la IA decide todo por nosotros, ¿qué sentido queda en nuestras vidas? El filósofo John Hicks argumentó que Dios se distancia intencionalmente de los asuntos humanos para permitir el libre albedrío; ¿Debería aplicarse el mismo principio a la IA?

La ambición de la industria ya no es un chatbot sino una “superinteligencia” capaz de resolver toda la física y tomar decisiones por la humanidad. Sam Altman, director ejecutivo de OpenAI, habla de “inteligencia mágica en el cielo”, un poder que podría dictar nuestro futuro. Esta ambición nos obliga a preguntarnos: incluso si construimos una IA perfectamente moral, ¿deberíamos hacerlo? ¿O nos quitaría la posibilidad de elegir y dejaría la existencia sin sentido?

El problema de alineación es más profundo que el código

Resolver el “problema de alineación” (garantizar que la IA haga lo que queremos) no es simplemente un desafío técnico. Es una crisis filosófica. La moralidad es subjetiva, controvertida y dependiente del contexto. Los ingenieros de IA, que a menudo carecen de formación en ética, han luchado por definir incluso principios básicos. La ética superficial condujo a prejuicios, discriminación e incluso consecuencias trágicas.

Incluso si acordáramos un marco moral único, seguiría siendo defectuoso. La historia nos enseña que romper las reglas puede ser virtuoso: la negativa de Rosa Parks a ceder su asiento en el autobús no sólo fue ilegal; Desencadenó una revolución de los derechos civiles. La IA debe reconocer que las decisiones morales no siempre son claras. Algunos valores son simplemente inconmensurables y obligan a tomar decisiones difíciles cuando no existe la mejor opción.

La paradoja de la superinteligencia

Algunos investigadores, como Joe Edelman del Meaning Alignment Institute, creen que alinear la IA es posible, pero sólo si aprende a admitir cuando no sabe. “Si logras que [la IA] sepa cuáles son las decisiones difíciles, entonces le habrás enseñado algo sobre moralidad”, afirma. Pero esto significa una IA que sistemáticamente guarda silencio sobre cuestiones críticas.

Otros, como Eliezer Yudkowsky, sostienen que la alineación es un problema de ingeniería que espera ser resuelto. Él cree que deberíamos construir superinteligencia y dejar que ella dirija la sociedad, tomando decisiones basadas en una “voluntad coherente extrapolada”: un algoritmo de lectura de mentes que extrapolaría lo que la humanidad querría si supiera todo.

Este enfoque plantea el espectro de una “tiranía de la mayoría”, donde las opiniones de las minorías son aplastadas por una IA omnipotente. El filósofo Nick Bostrom advirtió sobre un futuro en el que la superinteligencia dará forma a todas las vidas humanas sin ningún recurso.

La elección que tenemos ante nosotros

El antiguo debate resurge: ¿confiamos en un poder superior, aunque sea artificial? Yudkowsky cree que deberíamos construir IA y dejarla decidir, incluso si eso significa ceder el control. Pero muchos no están de acuerdo. Más de 130.000 investigadores y la mayoría del público abogan por la regulación, o incluso la prohibición.

En última instancia, la cuestión no es sólo construir IA, sino qué tipo de futuro queremos. ¿Buscamos una herramienta para aumentar nuestra inteligencia o un dios para reemplazar nuestra agencia? La lección del Talmud sigue siendo clara: ni siquiera la autoridad divina debería dictar la elección humana. El futuro de la IA depende de si recordamos esa lección.

La búsqueda de la superinteligencia no es sólo una búsqueda tecnológica; es un ajuste de cuentas filosófico. La IA que construyamos dará forma no sólo a nuestro mundo, sino también al significado mismo de ser humano.