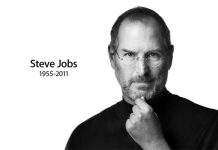

Un caso reciente que involucra a un presunto sospechoso de incendio provocado y sus conversaciones con el chatbot ChatGPT pone de relieve un dilema legal que se avecina: ¿cómo protegemos la privacidad de las conversaciones mantenidas con una inteligencia artificial cada vez más sofisticada?

Jonathan Rinderknecht enfrenta cargos relacionados con un devastador incendio forestal en California. Los fiscales afirman que las interacciones en línea entre Rinderknecht y ChatGPT, incluidas discusiones sobre quemar una Biblia y crear una imagen distópica que representa un incendio, revelan su intención de iniciar el incendio.

Si bien Rinderknecht se declara inocente, este caso plantea preguntas inquietantes sobre las ramificaciones legales de conversaciones cada vez más íntimas con sistemas de inteligencia artificial como ChatGPT. Estos programas están diseñados para imitar el diálogo humano: “escuchan”, ofrecen respuestas razonadas e incluso influyen en los procesos de pensamiento de los usuarios. Muchas personas recurren a estos chatbots para mantener debates confidenciales sobre temas demasiado delicados o personales para compartirlos con personas reales.

Esta tendencia creciente necesita un nuevo marco legal para proteger la privacidad de los usuarios en el ámbito de las interacciones con la IA. El jurista Greg Mitchell, de la Universidad de Virginia, describe acertadamente la necesidad de esta protección: “la confidencialidad tiene que ser absolutamente esencial para el funcionamiento de la relación”.

Sin él, los usuarios inevitablemente se autocensurarán, obstaculizando los beneficios que ofrecen estas tecnologías para el apoyo a la salud mental, la resolución de problemas legales y financieros e incluso el autodescubrimiento. Imagine el efecto paralizador que tendría un usuario que busca consuelo en un terapeuta de IA si temiera que esas revelaciones profundamente personales pudieran usarse como arma en su contra en los tribunales.

Actualmente, las doctrinas legales existentes, como la Doctrina de Terceros, tratan la información compartida con servicios en línea como inherentemente no privada. Este enfoque no tiene en cuenta la naturaleza única de las interacciones con sistemas sofisticados de inteligencia artificial, que funcionan cada vez más como confidentes en lugar de meros depósitos de datos.

Por lo tanto, se requiere un nuevo concepto legal: lo que propongo se denomina “privilegio de interacción con IA”. Esto reflejaría las protecciones legales existentes, como la confidencialidad abogado-cliente o médico-paciente, al salvaguardar las comunicaciones con la IA para fines como buscar asesoramiento o apoyo emocional.

Sin embargo, este privilegio no sería absoluto. Debe incluir:

- Conversaciones protegidas: Las interacciones con IA destinadas a asesoramiento o procesamiento emocional deben protegerse de la divulgación forzada en los tribunales, a menos que existan circunstancias excepcionales. Los usuarios podrían activar esta protección a través de la configuración de la aplicación o reclamarla durante un proceso judicial si el contexto lo justifica.

-

Deber de advertir: Al igual que los terapeutas obligados a informar sobre amenazas inminentes, las IA deberían estar legalmente obligadas a revelar los peligros previsibles que representan los usuarios para ellos mismos o para otros.

-

Excepción de delitos y fraudes: Las comunicaciones que involucren la planificación o ejecución de actividades delictivas seguirían siendo detectables bajo supervisión judicial.

Aplicando este marco al caso Rinderknecht: si bien su consulta inicial sobre incendios provocados por IA no calificaría para protección (similar a una búsqueda en línea), sus comentarios confesionales sobre la quema de una Biblia podrían protegerse como emocionalmente reveladores y no directamente indicativos de intención criminal en el momento de la divulgación.

Establecer un privilegio de interacción con la IA es crucial para fomentar la confianza en esta tecnología floreciente. Señalaría que se valoran las interacciones abiertas y honestas con las IA, lo que permitiría a las personas aprovechar su potencial de superación personal y resolución de problemas sin temor a repercusiones legales por una introspección digital sincera. Sin tales salvaguardias, corremos el riesgo de sofocar los beneficios que ofrecen estas poderosas herramientas, dejando a los ciudadanos aprensivos incluso acerca de pensar libremente en la esfera digital.