Depuis deux millénaires, une question fondamentale résonne à travers l’histoire de l’humanité : devons-nous suivre aveuglément l’autorité, même divine, ou nous réserver le droit de faire nos propres choix ? Ce débat ancien, né de la loi juive du premier siècle, est désormais au cœur de l’avenir de l’intelligence artificielle.

L’histoire raconte que le rabbin Eliezer, un sage convaincu de sa propre justesse, a accompli des miracles pour prouver son point de vue. Il a fait bouger les arbres, inverser les rivières et effondrer les salles d’étude, aboutissant à une voix retentissante venant du ciel lui donnant raison. Pourtant, les autres sages l’ont annulé, déclarant que la loi repose sur la prise de décision humaine et non sur un décret divin. « La Torah n’est pas au paradis ! » ils ont insisté.

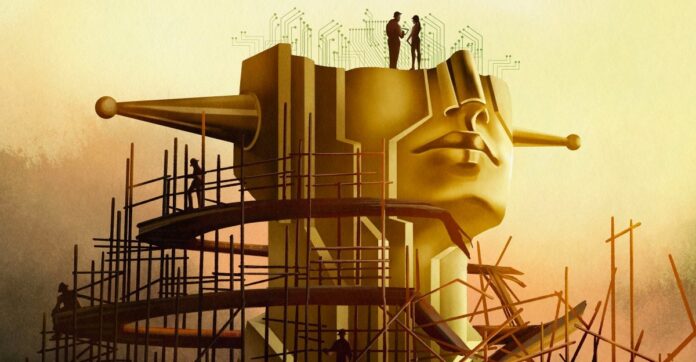

Il ne s’agit pas simplement d’une dispute théologique archaïque ; c’est un modèle pour le dilemme actuel de l’IA. Le développement moderne de l’IA, en particulier la recherche de la « superintelligence », passe rapidement de la création d’outils utiles à la construction d’une entité semblable à Dieu dotée d’un pouvoir inimaginable. Mais même si une telle IA est parfaitement alignée sur les valeurs humaines, faut-il céder le contrôle ?

L’illusion de l’alignement

Les experts parlent d’aligner l’IA sur les valeurs humaines, mais le véritable alignement ne consiste pas simplement à empêcher les résultats nuisibles. Il s’agit de préserver l’action humaine. Si l’IA décide de tout à notre place, quel sens reste-t-il à nos vies ? Le philosophe John Hicks a soutenu que Dieu se distancie intentionnellement des affaires humaines pour permettre le libre arbitre ; le même principe devrait-il s’appliquer à l’IA ?

L’ambition de l’industrie n’est plus un chatbot mais une « superintelligence » capable de résoudre toute la physique et de prendre des décisions pour l’humanité. Sam Altman, PDG d’OpenAI, parle d’une « intelligence magique dans le ciel », une puissance qui pourrait dicter notre avenir. Cette ambition nous oblige à nous demander : même si nous construisons une IA parfaitement morale, le devrions-nous ? Ou cela nous priverait-il de choix, rendant l’existence dénuée de sens ?

Le problème d’alignement est plus profond que le code

Résoudre le « problème d’alignement » – garantir que l’IA fait ce que nous voulons – n’est pas simplement un défi technique. C’est une crise philosophique. La moralité est subjective, contestée et dépend du contexte. Les ingénieurs en IA, souvent dépourvus de formation en éthique, ont eu du mal à définir ne serait-ce que les principes de base. Une éthique superficielle a conduit à des préjugés, à de la discrimination et même à des conséquences tragiques.

Même si nous nous mettions d’accord sur un cadre moral unique, celui-ci serait toujours imparfait. L’histoire nous enseigne qu’enfreindre les règles peut être vertueux : le refus de Rosa Parks de céder son siège dans l’autobus n’était pas seulement illégal ; cela a déclenché une révolution des droits civiques. L’IA doit reconnaître que les choix moraux ne sont pas toujours clairs. Certaines valeurs sont tout simplement incommensurables, obligeant à des choix difficiles là où il n’existe pas de meilleure option.

Le paradoxe de la superintelligence

Certains chercheurs, comme Joe Edelman du Meaning Alignment Institute, pensent qu’il est possible d’aligner l’IA, mais seulement si elle apprend à admettre qu’elle ne sait pas. “Si vous faites savoir à [l’IA] quels sont les choix difficiles, alors vous lui avez appris quelque chose sur la moralité”, dit-il. Mais cela signifie une IA qui reste systématiquement silencieuse sur les questions critiques.

D’autres, comme Eliezer Yudkowsky, soutiennent que l’alignement est un problème d’ingénierie qui attend d’être résolu. Il pense que nous devrions construire une superintelligence et la laisser diriger la société, en prenant des décisions basées sur une « volonté extrapolée cohérente » – un algorithme de lecture des pensées qui extrapolerait ce que l’humanité voudrait si elle savait tout.

Cette approche soulève le spectre d’une « tyrannie de la majorité », où les opinions minoritaires sont écrasées par une IA toute-puissante. Le philosophe Nick Bostrom a mis en garde contre un avenir où la superintelligence façonnerait toutes les vies humaines sans aucun recours.

Le choix qui s’offre à nous

L’ancien débat refait surface : fait-on confiance à une puissance supérieure, même artificielle ? Yudkowsky estime que nous devrions construire l’IA et la laisser décider, même si cela signifie abandonner le contrôle. Mais beaucoup ne sont pas d’accord. Plus de 130 000 chercheurs et une majorité du public plaident en faveur d’une réglementation, voire d’une interdiction.

En fin de compte, la question ne concerne pas seulement la construction de l’IA, mais aussi le type d’avenir que nous souhaitons. Cherchons-nous un outil pour augmenter notre intelligence, ou un dieu pour remplacer notre libre arbitre ? La leçon du Talmud reste claire : même l’autorité divine ne devrait pas dicter les choix humains. L’avenir de l’IA dépend de la mémorisation de cette leçon.

La quête de la superintelligence n’est pas seulement une quête technologique ; c’est un calcul philosophique. L’IA que nous construisons façonnera non seulement notre monde, mais aussi le sens même de l’être humain.