Per due millenni, una domanda fondamentale ha echeggiato nella storia umana: dovremmo seguire ciecamente l’autorità, anche quella divina, o riservarci il diritto di fare le nostre scelte? Questo antico dibattito, che ha origine nella legge ebraica del I secolo, è ora centrale per il futuro dell’intelligenza artificiale.

La storia racconta che il rabbino Eliezer, un saggio convinto della propria correttezza, compì miracoli per dimostrare la sua tesi. Fece muovere gli alberi, invertire i fiumi e far crollare le aule di studio, culminando con una voce tonante dal cielo che gli dichiarava giusto. Tuttavia, gli altri saggi lo prevalsero, dichiarando che la legge si basa sul processo decisionale umano, non sul decreto divino. “La Torah non è in paradiso!” hanno insistito.

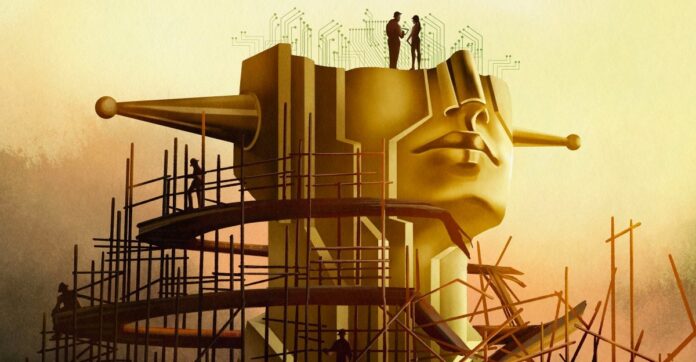

Questa non è solo una disputa teologica arcaica; è un modello per il dilemma dell’intelligenza artificiale di oggi. Lo sviluppo moderno dell’intelligenza artificiale, in particolare la ricerca della “superintelligenza”, si sta rapidamente spostando dalla creazione di strumenti utili alla costruzione di un’entità simile a un dio con un potere inimmaginabile. Ma anche se tale intelligenza artificiale fosse perfettamente allineata ai valori umani, dovremmo cedere il controllo?

L’illusione dell’allineamento

Gli esperti parlano di allineare l’intelligenza artificiale ai valori umani, ma il vero allineamento non consiste semplicemente nel prevenire risultati dannosi. Si tratta di preservare l’azione umana. Se l’AI decide tutto per noi, che senso resta nelle nostre vite? Il filosofo John Hicks ha sostenuto che Dio prende intenzionalmente le distanze dagli affari umani per consentire il libero arbitrio; lo stesso principio dovrebbe applicarsi all’IA?

L’ambizione del settore non è più un chatbot ma una “superintelligenza” in grado di risolvere tutti i problemi della fisica e prendere decisioni per l’umanità. Il CEO di OpenAI Sam Altman parla di “intelligenza magica nel cielo”, un potere che potrebbe dettare il nostro futuro. Questa ambizione ci costringe a chiederci: anche se costruissimo un’intelligenza artificiale perfettamente morale, dovremmo farlo? Oppure ci priverebbe della scelta, rendendo l’esistenza priva di significato?

Il problema dell’allineamento è più profondo del codice

Risolvere il “problema di allineamento” – garantire che l’intelligenza artificiale faccia ciò che vogliamo – non è semplicemente una sfida tecnica. È una crisi filosofica. La moralità è soggettiva, contestata e dipendente dal contesto. Gli ingegneri dell’intelligenza artificiale, spesso privi di formazione in campo etico, hanno faticato a definire anche i principi di base. L’etica superficiale ha portato a pregiudizi, discriminazioni e persino conseguenze tragiche.

Anche se concordassimo su un unico quadro morale, esso sarebbe comunque imperfetto. La storia ci insegna che infrangere le regole può essere virtuoso: il rifiuto di Rosa Parks di rinunciare al suo posto sull’autobus non era solo illegale; ha scatenato una rivoluzione per i diritti civili. L’intelligenza artificiale deve riconoscere che le scelte morali non sono sempre chiare. Alcuni valori sono semplicemente incommensurabili, costringendo a scelte difficili laddove non esiste l’opzione migliore.

Il paradosso della superintelligenza

Alcuni ricercatori, come Joe Edelman del Meaning Alignment Institute, credono che allineare l’intelligenza artificiale sia possibile, ma solo se impara ad ammettere quando non lo sa. “Se riesci a far sì che [l’intelligenza artificiale] sappia quali sono le scelte difficili, allora le hai insegnato qualcosa sulla moralità”, afferma. Ma questo significa un’intelligenza artificiale che tace sistematicamente sulle questioni critiche.

Altri, come Eliezer Yudkowsky, sostengono che l’allineamento è un problema di ingegneria in attesa di essere risolto. Crede che dovremmo costruire una superintelligenza e lasciare che sia lei a gestire la società, prendendo decisioni basate su una “volontà estrapolata coerente” – un algoritmo di lettura della mente che estrapolerebbe ciò che l’umanità vorrebbe se sapesse tutto.

Questo approccio solleva lo spettro di una “tirannia della maggioranza”, in cui le opinioni delle minoranze vengono schiacciate da un’intelligenza artificiale onnipotente. Il filosofo Nick Bostrom metteva in guardia da un futuro in cui la superintelligenza plasmerà tutte le vite umane senza alcuna possibilità di ricorso.

La scelta davanti a noi

Riaffiora l’antico dibattito: ci fidiamo di un potere superiore, anche se artificiale? Yudkowsky ritiene che dovremmo costruire l’intelligenza artificiale e lasciare che sia lei a decidere, anche se ciò significa cedere il controllo. Ma molti non sono d’accordo. Oltre 130.000 ricercatori e la maggioranza del pubblico sostengono la regolamentazione o addirittura la proibizione.

In definitiva, la questione non riguarda solo la creazione dell’intelligenza artificiale, ma il tipo di futuro che vogliamo. Cerchiamo uno strumento per aumentare la nostra intelligenza o un dio per sostituire il nostro libero arbitrio? La lezione del Talmud rimane chiara: nemmeno l’autorità divina dovrebbe dettare la scelta umana. Il futuro dell’intelligenza artificiale dipende dalla capacità di ricordare quella lezione.

La ricerca della superintelligenza non è solo una ricerca tecnologica; è un calcolo filosofico. L’intelligenza artificiale che costruiremo darà forma non solo al nostro mondo, ma al significato stesso dell’essere umano.