Al twee millennia lang echoot een fundamentele vraag door de geschiedenis van de mensheid: moeten we blindelings autoriteit volgen, zelfs goddelijke autoriteit, of ons het recht voorbehouden om onze eigen keuzes te maken? Dit eeuwenoude debat, dat zijn oorsprong vindt in het joodse recht uit de eerste eeuw, staat nu centraal in de toekomst van kunstmatige intelligentie.

Het verhaal gaat dat rabbijn Eliëzer, een wijze die overtuigd was van zijn eigen juistheid, wonderen verrichtte om zijn punt te bewijzen. Hij liet bomen bewegen, rivieren keren en studiezalen instorten, met als hoogtepunt een dreunende stem uit de hemel die hem gelijk gaf. Toch overwonnen de andere wijzen hem en verklaarden dat de wet berust bij menselijke besluitvorming, en niet bij goddelijk besluit. “De Thora is niet in de hemel!” ze stonden erop.

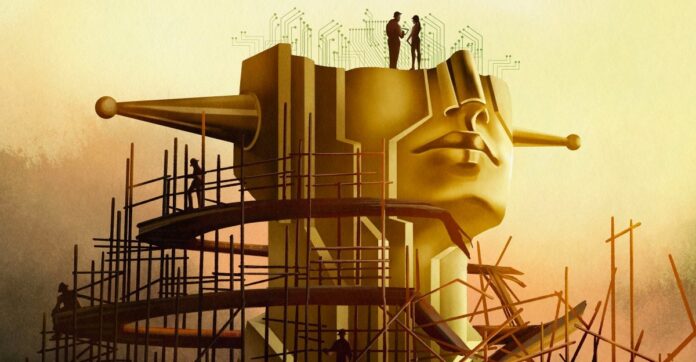

Dit is niet alleen een archaïsch theologisch dispuut; het is een blauwdruk voor het huidige AI-dilemma. De moderne AI-ontwikkeling, met name het streven naar ‘superintelligentie’, verschuift snel van het bouwen van nuttige hulpmiddelen naar het construeren van een goddelijke entiteit met onvoorstelbare kracht. Maar zelfs als een dergelijke AI perfect aansluit bij de menselijke waarden, moeten we dan de controle uit handen geven?

De illusie van afstemming

Experts praten over het afstemmen van AI op menselijke waarden, maar echte afstemming gaat niet alleen over het voorkomen van schadelijke resultaten. Het gaat om het behoud van de menselijke keuzevrijheid. Als AI alles voor ons beslist, welke betekenis blijft er dan over in ons leven? Filosoof John Hicks voerde aan dat God opzettelijk afstand neemt van menselijke aangelegenheden om vrije wil mogelijk te maken; Moet hetzelfde principe gelden voor AI?

De ambitie van de industrie is niet langer een chatbot, maar een ‘superintelligentie’ die in staat is de hele natuurkunde op te lossen en beslissingen te nemen voor de mensheid. OpenAI-CEO Sam Altman spreekt over ‘magische intelligentie in de lucht’, een kracht die onze toekomst zou kunnen dicteren. Deze ambitie dwingt ons de vraag te stellen: zelfs als we een volkomen morele AI zouden bouwen, zouden we dat dan wel moeten doen? Of zou het ons de keuzevrijheid ontnemen, waardoor het bestaan zinloos wordt?

Het uitlijningsprobleem gaat dieper dan code

Het oplossen van het ‘uitlijningsprobleem’ – ervoor zorgen dat AI doet wat we willen – is niet alleen een technische uitdaging. Het is een filosofische crisis. Moraliteit is subjectief, omstreden en contextafhankelijk. AI-ingenieurs, die vaak geen opleiding in ethiek hebben, hebben moeite om zelfs maar de basisprincipes te definiëren. Oppervlakkige ethiek leidde tot vooringenomenheid, discriminatie en zelfs tragische gevolgen.

Zelfs als we het eens zouden worden over één enkel moreel raamwerk, zou het nog steeds gebrekkig zijn. De geschiedenis leert ons dat het overtreden van regels deugdzaam kan zijn: de weigering van Rosa Parks om haar busstoel op te geven was niet alleen illegaal; het leidde tot een burgerrechtenrevolutie. AI moet erkennen dat morele keuzes niet altijd duidelijk zijn. Sommige waarden zijn eenvoudigweg niet te vergelijken en dwingen tot moeilijke keuzes waar geen beste optie bestaat.

De paradox van superintelligentie

Sommige onderzoekers, zoals Joe Edelman van het Meaning Alignment Institute, geloven dat het op één lijn brengen van AI mogelijk is, maar alleen als het leert toe te geven wanneer het het niet weet. “Als je [de AI] laat weten wat de moeilijke keuzes zijn, dan heb je hem iets over moraliteit geleerd”, zegt hij. Maar dit betekent een AI die systematisch zwijgt over kritieke kwesties.

Anderen, zoals Eliezer Yudkowsky, beweren dat uitlijning een technisch probleem is dat wacht op een oplossing. Hij is van mening dat we superintelligentie moeten opbouwen en deze de samenleving moeten laten besturen, waarbij we beslissingen moeten nemen op basis van ‘coherente geëxtrapoleerde wilskracht’ – een algoritme voor het lezen van gedachten dat zou extrapoleren wat de mensheid zou willen als ze alles zou weten.

Deze aanpak roept het schrikbeeld op van een ‘tirannie van de meerderheid’, waarbij de standpunten van minderheden worden verpletterd door een almachtige AI. Filosoof Nick Bostrom waarschuwde voor een toekomst waarin superintelligentie alle mensenlevens vormgeeft zonder enige vorm van verhaal.

De keuze die voor ons ligt

Het eeuwenoude debat duikt weer op: vertrouwen we een hogere macht, ook al is die kunstmatig? Yudkowsky is van mening dat we AI moeten bouwen en deze moeten laten beslissen, zelfs als dat betekent dat we de controle moeten opgeven. Maar velen zijn het daar niet mee eens. Ruim 130.000 onderzoekers en een meerderheid van het publiek pleiten voor regulering of zelfs een verbod.

Uiteindelijk gaat de vraag niet alleen over het bouwen van AI, maar over wat voor soort toekomst we willen. Zoeken we een instrument om onze intelligentie te vergroten, of een god die onze keuzevrijheid vervangt? De les van de Talmoed blijft duidelijk: zelfs goddelijk gezag mag de menselijke keuze niet dicteren. De toekomst van AI hangt af van de vraag of we die les onthouden.

Het streven naar superintelligentie is niet alleen een technologische zoektocht; het is een filosofische afrekening. De AI die we bouwen zal niet alleen onze wereld vormgeven, maar ook de betekenis van het mens-zijn.