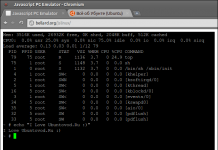

Загальний перехід до паралельної обробки даних і кардинальне збільшення розміру нейромереж призвели до того, що деякі типи обчислень зараз вимагають дуже швидкого доступу до пам’яті. У той же час розрив у швидкості доступу між мікросхемою cpu і оперативною пам’яттю надзвичайно великий. Процесори стають все швидше, а швидкість доступу до dram практично не зростає.

Оригінальна комп’ютерна архітектура фон неймана не передбачала поділ логіки і пам’яті. Але прогрес не стоїть на місці — і ось уже кілька виробників розробили інтегровані модулі типу processing-in-memory (pim). Це samsung, sk hynix і ізраїльський стартап neuroblade.

Завдяки перенесенню частини логіки в мікросхеми пам’яті скорочується трафік між cpu і dram, тобто менше даних переміщається між чіпами. За деякими оцінками, з точки зору енерговитрат переміщення даних з пам’яті обходиться приблизно в 650 разів дорожче, ніж операція множення в cpu.

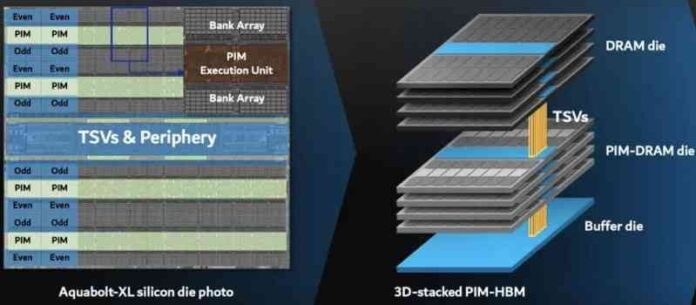

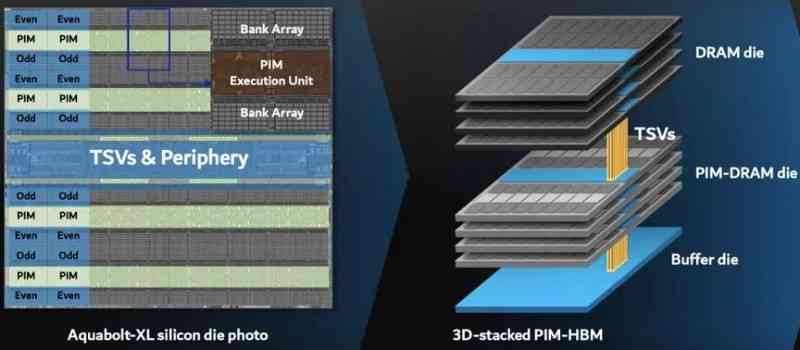

Звичайно, обчислення в пам’яті — це не нова ідея. Але можливо, що зараз її час нарешті прийшов, пише ieee spectrum. Минулого року таку технологію почала впроваджувати samsung. У лютому 2021 року вона інтегрувала обчислювальні ядра в пам’ять з високою пропускною здатністю aquabolt-xl. Це високопродуктивна пам’ять, яку встановлюють в спеціалізовані прискорювачі ai.

Нова пам’ять hbm-pim покликана замінити звичайні чіпи hbm.

Наприклад, з ai-прискорювачем xilinx alveo технологія pim забезпечує майже 2,5-кратний приріст продуктивності і зниження енергоспоживання на 62% в нейромережі розпізнавання мови.

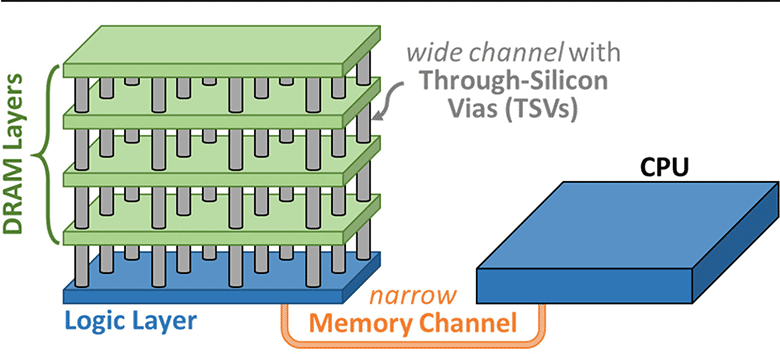

Samsung планує розробити pim також для наступного покоління dram з низьким енергоспоживанням в мобільних пристроях. Цей стандарт буде прийнятий jedec орієнтовно в i пол. 2022 року.існує безліч способів додати обчислювальні можливості в чіпи пам’яті. Samsung вибрала просту і ефективну конструкцію: стопка мікросхем dram вертикально прошита «каналами крізь кремній» (through-silicon vias, tsv). На нижньому шарі лежить логічна мікросхема, яка служить інтерфейсом до процесора.

Крім samsung, технологію pim впроваджують і інші компанії. Другий за величиною виробник пам’яті sk hynix спільно з університетом пердью ще в 2020 році представив архітектуру спеціалізованого ai-прискорювача newton з ядрами обчислювачів в пам’яті типу hbm-pim, але компанія вирішила не випускати його в продаж і замість цього зайнятися розробкою pim для стандартних модулів dram.