Od dwóch tysiącleci ludzkość zadaje sobie zasadnicze pytanie: czy powinniśmy ślepo podążać za autorytetami, nawet boskimi, czy też zachować prawo do podejmowania własnych decyzji? Ta starożytna debata, która rozpoczęła się w pierwszym wieku naszej ery w prawie żydowskim, obecnie leży u podstaw przyszłości sztucznej inteligencji.

Według legendy rabin Eliezer, przekonany o swojej racji, dokonywał cudów, aby udowodnić swoje racje. Sprawił, że drzewa się poruszyły, rzeki cofnęły, a ściany synagogi się rozpadły, aż w końcu usłyszał donośny głos z nieba potwierdzający, że miał rację. Jednak inni mędrcy odrzucili to, twierdząc, że prawo opiera się na ludzkich decyzjach, a nie na rozkazie Boga. „Tory nie ma w niebie!” – nalegali.

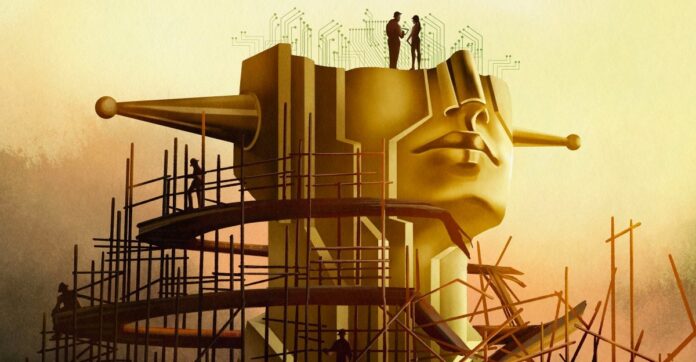

To nie jest tylko archaiczna debata teologiczna; to jest plan współczesnego dylematu AI. Współczesny rozwój sztucznej inteligencji, zwłaszcza dążenie do „superinteligencji”, szybko przechodzi od tworzenia przydatnych narzędzi do konstruowania boskiej istoty o niewyobrażalnej mocy. Ale nawet gdyby taka sztuczna inteligencja była idealnie zgodna z ludzkimi wartościami, czy powinniśmy oddać jej kontrolę?

Iluzja zgodności

Eksperci mówią o dostosowaniu sztucznej inteligencji do wartości ludzkich, ale prawdziwe dostosowanie nie polega tylko na zapobieganiu szkodliwym skutkom. Na tym polega zachowanie ludzkiej autonomii. Jeśli sztuczna inteligencja będzie decydować za nas o wszystkim, jaki sens pozostanie w naszym życiu? Filozof John Hicks argumentował, że Bóg celowo dystansuje się od spraw ludzkich, aby pozwolić na wolną wolę; czy ta sama zasada powinna mieć zastosowanie do sztucznej inteligencji?

Ambicje branży nie ograniczają się już do chatbota, ale do stworzenia „superinteligencji” zdolnej do rozwiązywania wszystkich problemów fizyki i podejmowania decyzji za ludzkość. Dyrektor generalny OpenAI, Sam Altman, mówi o „magicznej inteligencji w przestworzach”, sile zdolnej do kształtowania naszej przyszłości. Ta ambicja zmusza nas do zadania pytania: czy nawet jeśli zbudujemy doskonale moralną sztuczną inteligencję, czy powinniśmy to zrobić? A może pozbawi nas wyboru, czyniąc istnienie bezsensownym?

Problem zgodności jest głębszy niż kod

Rozwiązanie „problemu zgodności” — zapewnienie, że sztuczna inteligencja robi to, czego chcemy — to nie tylko wyzwanie techniczne. To kryzys filozoficzny. Moralność jest subiektywna, kontrowersyjna i zależy od kontekstu. Inżynierowie AI, często bez wiedzy etycznej, mają trudności ze zdefiniowaniem nawet podstawowych zasad. Płytka etyka doprowadziła do uprzedzeń, dyskryminacji, a nawet tragicznych konsekwencji.

Nawet gdybyśmy zgodzili się na jednolite ramy moralne, nadal byłyby one niedoskonałe. Historia uczy nas, że łamanie zasad może być cnotliwe: odmowa Rosy Parks ustąpienia miejsca w autobusie była nie tylko nielegalna; wywołał rewolucję praw obywatelskich. Sztuczna inteligencja musi zrozumieć, że wybory moralne nie zawsze są oczywiste. Niektóre wartości są po prostu nieporównywalne, wymuszając trudne wybory tam, gdzie nie ma lepszej opcji.

Paradoks wykraczający poza inteligencję

Niektórzy badacze, na przykład Joe Edelman z Instytutu Negocjacji Znaczeń, uważają, że uspójnienie sztucznej inteligencji jest możliwe, ale tylko wtedy, gdy nauczy się przyznawać, że nie zna odpowiedzi. „Jeśli sprawisz, że [AI] zrozumie, które wybory są trudne, nauczysz ją czegoś o moralności” – mówi. Ale to oznacza sztuczną inteligencję, która systematycznie milczy w kluczowych kwestiach.

Inni, jak Eliezer Yudkowsky, twierdzą, że zgodność to problem inżynieryjny, który należy rozwiązać. Uważa, że powinniśmy zbudować superinteligencję i pozwolić jej rządzić społeczeństwem poprzez podejmowanie decyzji w oparciu o „spójną ekstrapolowaną wolę” – algorytm czytania w myślach, który ekstrapoluje, czego chciałaby ludzkość, gdyby wiedziała wszystko.

Takie podejście rodzi widmo „tyranii większości”, w której opinie mniejszości są tłumione przez wszechpotężną sztuczną inteligencję. Filozof Nick Bostrom ostrzegał przed przyszłością, w której superinteligencja będzie bez reszty kształtować całe ludzkie życie.

Wybór jest przed nami

Wznawia się starożytna debata: Czy ufamy sile wyższej, nawet jeśli jest sztuczna? Yudkowsky uważa, że powinniśmy zbudować sztuczną inteligencję i pozwolić jej decydować, nawet jeśli oznacza to utratę kontroli. Ale wielu się z tym nie zgadza. Ponad 130 000 badaczy i większość społeczeństwa opowiada się za regulacją lub nawet zakazem.

Ostatecznie pytanie nie dotyczy tylko stworzenia sztucznej inteligencji, ale także tego, jakiej przyszłości chcemy. Czy szukamy narzędzia poszerzającego naszą inteligencję, czy też boga, który zastąpi naszą autonomię? Lekcja z Talmudu pozostaje jasna: nawet boska władza nie powinna dyktować ludzkich wyborów. Przyszłość sztucznej inteligencji zależy od tego, czy zapamiętamy tę lekcję.

Dążenie do superinteligencji to nie tylko poszukiwanie technologiczne; jest to rewizja filozoficzna. Sztuczna inteligencja, którą stworzymy, ukształtuje nie tylko nasz świat, ale sam sens ludzkiej egzystencji.