Durante dois milénios, uma questão fundamental ecoou através da história humana: deveríamos seguir cegamente a autoridade, mesmo a autoridade divina, ou reservar-nos o direito de fazer as nossas próprias escolhas? Este antigo debate, originado na lei judaica do primeiro século, é agora central para o futuro da inteligência artificial.

A história conta que o rabino Eliezer, um sábio convencido de sua correção, realizou milagres para provar seu ponto de vista. Ele fez as árvores se moverem, os rios reverterem e as salas de estudo desabarem, culminando com uma voz estrondosa do céu declarando que ele estava certo. No entanto, os outros sábios o rejeitaram, declarando que a lei depende da tomada de decisão humana, e não do decreto divino. “A Torá não está no céu!” eles insistiram.

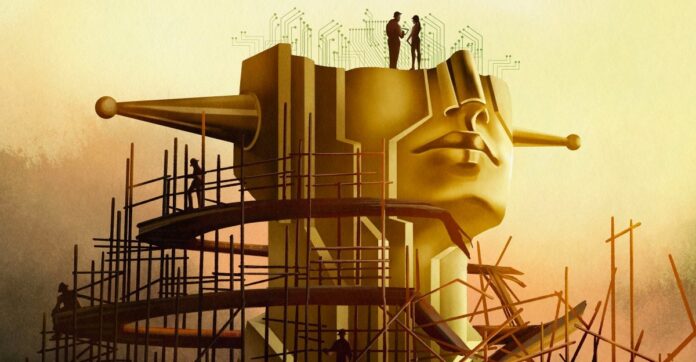

Esta não é apenas uma disputa teológica arcaica; é um modelo para o dilema atual da IA. O desenvolvimento moderno da IA, particularmente a busca pela “superinteligência”, está mudando rapidamente da construção de ferramentas úteis para a construção de uma entidade semelhante a um deus com poder inimaginável. Mas mesmo que tal IA esteja perfeitamente alinhada com os valores humanos, deveríamos ceder o controlo?

A Ilusão do Alinhamento

Os especialistas falam sobre alinhar a IA com os valores humanos, mas o verdadeiro alinhamento não consiste simplesmente em prevenir resultados prejudiciais. Trata-se de preservar a agência humana. Se a IA decide tudo por nós, que significado resta nas nossas vidas? O filósofo John Hicks argumentou que Deus se distancia intencionalmente dos assuntos humanos para permitir o livre arbítrio; o mesmo princípio deveria ser aplicado à IA?

A ambição da indústria não é mais um chatbot, mas uma “superinteligência” capaz de resolver toda a física e tomar decisões para a humanidade. O CEO da OpenAI, Sam Altman, fala de “inteligência mágica no céu”, um poder que pode ditar o nosso futuro. Esta ambição obriga-nos a perguntar: mesmo que construamos uma IA perfeitamente moral, deveríamos? Ou isso nos privaria de escolha, tornando a existência sem sentido?

O problema de alinhamento é mais profundo que o código

Resolver o “problema de alinhamento” – garantir que a IA faça o que queremos – não é apenas um desafio técnico. É uma crise filosófica. A moralidade é subjetiva, contestada e dependente do contexto. Os engenheiros de IA, muitas vezes sem formação em ética, têm lutado para definir até mesmo os princípios básicos. A ética superficial levou a preconceitos, discriminação e até consequências trágicas.

Mesmo que concordássemos com um quadro moral único, este ainda seria falho. A história ensina-nos que quebrar regras pode ser virtuoso: a recusa de Rosa Parks em ceder o seu lugar no autocarro não foi apenas ilegal; desencadeou uma revolução nos direitos civis. A IA deve reconhecer que as escolhas morais nem sempre são claras. Alguns valores são simplesmente incomensuráveis, forçando escolhas difíceis onde não existe a melhor opção.

O Paradoxo da Superinteligência

Alguns pesquisadores, como Joe Edelman, do Meaning Alignment Institute, acreditam que alinhar a IA é possível, mas apenas se ela aprender a admitir quando não sabe. “Se você conseguir que [a IA] saiba quais são as escolhas difíceis, então você lhe ensinou algo sobre moralidade”, diz ele. Mas isto significa uma IA que sistematicamente se cala sobre questões críticas.

Outros, como Eliezer Yudkowsky, argumentam que o alinhamento é um problema de engenharia à espera de ser resolvido. Ele acredita que deveríamos construir uma superinteligência e deixá-la governar a sociedade, tomando decisões baseadas numa “vontade extrapolada coerente” – um algoritmo de leitura de mentes que extrapolaria o que a humanidade desejaria se soubesse tudo.

Esta abordagem levanta o espectro de uma “tirania da maioria”, onde as opiniões minoritárias são esmagadas por uma IA omnipotente. O filósofo Nick Bostrom alertou sobre um futuro onde a superinteligência moldará todas as vidas humanas sem nenhum recurso.

A escolha diante de nós

O antigo debate ressurge: confiamos num poder superior, mesmo que seja artificial? Yudkowsky acredita que devemos construir a IA e deixá-la decidir, mesmo que isso signifique abrir mão do controle. Mas muitos discordam. Mais de 130.000 investigadores e a maioria do público defendem a regulamentação, ou mesmo a proibição.

Em última análise, a questão não é apenas construir IA, mas sim que tipo de futuro queremos. Procuramos uma ferramenta para aumentar a nossa inteligência ou um deus para substituir a nossa agência? A lição do Talmud permanece clara: mesmo a autoridade divina não deveria ditar a escolha humana. O futuro da IA depende de nos lembrarmos dessa lição.

A busca pela superinteligência não é apenas uma busca tecnológica; é um cálculo filosófico. A IA que construímos moldará não apenas o nosso mundo, mas o próprio significado de ser humano.